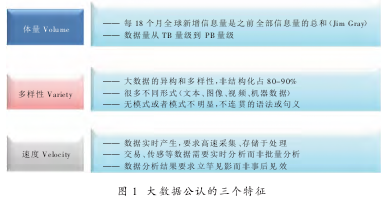

“大数据”意味着大量的非结构化和半结构化数据,它具有三个公认的特征———体量(Volume)、多样性(Variety)和速度(Velocity),即3V 特征(如图 1 所示)。对大数据的处理需要采用并行分布式架构和人工智能算法等新的技术,并以新的理念应用于辅助决策、优化流程和发现新的知识。

无论是大数据还是小数据,都是由数据采集、数据处理、计算处理、数据分析和数据展现等五个层次组成的。大数据的 3V 特征对于数据展现或者数据采集都会产生一些间接的影响,但对中间三个层次的技术提出了非常大的挑战,也促使这三个层次出现更大的变化。

海量存储管理技术

数据的存储分为两个层次,第一层是文件系统,第二层是数据库。文件系统把数据以非常便宜的方式放在物理机器中管理起来,它解决的是性能价格比问题。数据库是专门用于存、管理数据的一种特定程序,解决的是灵活性的问题,也就是如何把存储进来的数据以很高效的形式找出来。

在数据存储架构中,以前的数据存储与计算是分离的,比如,用IBM、EMC 等的 NAS、SAN 系统存储到网络里。另外一些服务器是进行计算的,处理数据的时候,要把数据从存储网络里调到计算节点上。由于文件系统的吞吐量和可扩展性差,假如数据量很大或者速度很快,就会在网络上产生瓶颈。后来,谷歌提出的技术改变了传统的处理思路,谷歌去掉了中间的存储网络,把存储和计算放在同一个物理机器上,降低了 I/O 成本、时间成本和建设成本。现在,谷歌的GFS 等都采用这种技术理念。这是一个大方向,当然,也还有一些小问题,比如,对于海量小文件来说,写操作的速度很慢,以前谷歌的网页所有系统写数据不频繁,但读数据很频繁。存储技术的发展需要突破 GFS/HDFS 在写操作、小文件存取等方面的性能瓶颈,设计新的文件系统。

在数据管理技术方面,原来的数据是表格形式,表格之间通过关系数据库(SQL)管理。其访问接口采用标准的 SQL 语言,编程很方便。不过,现在出现了非结构化的数据,视频、图片之类不能用传统的关系来存储和管理,这是存储格式要求放宽之后带来的问题,这种结构存下来数据很难管理和访问。

以前的数据库可以用 SQL 语言来调用并进行分析,现在是非结构化数据,需要方便的接口。放松一致性要求提升性能,通过 Key-Value、文件等存储增加灵活性,非关系型数据库(NoSQL)技术应运而生。新型数据库(NewSQL)有两个特点:内部存储是按对象或者按非结构的数据去处理,外面的操作可以用原有的 SQL 语言或类似语言来支持,具有融合关系型和非关系型数据库特点,研发超大规模的新型数据库是数据管理技术的发展方向。

并行计算技术

数据存储下来之后如何方便地查询?对于大数据量、复杂任务,最简单的想法是分而治之,也就是把一项复杂的任务拆分成多个很小的任务,分配给不同的机器去同时处理,再把结果合并起来,这样能够充分利用很多台机器同时运行。这是分布式计算最根本的思想,其优点是可以进行水平扩展,当一台机器不够的时候,能够增加一台机器来线性地扩充系统的能力。而在以前这样做是不行的,如果增加一台机器,那么新机器上的程序无法和原有的机器交互,也没有办法管理。水平扩展意味着这个系统的规模可以快速上升,而且几乎没有限制,这样可以适应大数据的存储、计算等能力扩张的要求,灵活性也很高。

其实,伴随上世纪 90 年代商业智能概念的提出,数据分析在企业中得到了应用,但应用不够广泛 。 2000年前后,谷歌提出MapReduce/BigTable 等技术,从此开启了数据分析的新阶段。如今,Google MapReduce 及其开源实现Hadoop 已经成为应用最广泛的大数据计算平台,但 MapReduce 架构并不是万能的,针对机器学习迭代、流处理等任务,计算时延过大。

目前,业界出现了多个不同的并行计算架构路线,它们都将在特定大数据处理中得到应用。

大规模分布式并行计算有多种计算模式,MapReduce 采用批计算的模式,先存储后计算。如果要马上产生结果,比如要搜一个微博,传统的方法可能要等微博发出去好几天之后才能搜到,而现在可以用实时批计算来处理。对于不同的场景有不同的计算模式,包括交互查询、图计算等等,计算技术的发展需要研发实时性高的大规模并行处理,支撑大规模机器学习的迭代运算。

数据分析技术

数据分析是大数据的核心,通过分析可以从数据里发现趋势或者规律。数据分成两类:非结构化和结构化的数据。在所有数据里,结构化的数据可能只占 20%左右,大量数据都是半结构或非结构化的数据。以前的数据分析技术只能分析结构化数据,如今,技术在发展,谷歌对搜索网页已经可以分析半结构化的数据,但对于占数量最多的图片、音频、视频还完全没有办法分析。

总的来讲,数据分析技术有两个需求:一是对传统的数据进行深度分析,二是对非结构化数据加以分析利用,比如图片、视频等。现在,城市里布下了很多视频监控探头,产生的数据量很大,如果在这些数据里搜索,靠机器没有用,这种搜索办法还需要突破。以前能分析的数据模型很简单,数据量也很小,现在需要针对新的需求来做分析。

数据分析技术以前也叫数据挖掘技术,它包括属性筛选、分类预测、回归预测、聚类分析、关联分析、时间序列等。传统的数据分析需要突破对非结构化数据的分析利用,另外,对海量的结构化数据的深度分析也难以应对。腾讯的推荐系统就需要考虑海量、复杂和多变的大数据需求。

腾讯 QQ 月活跃用户超过 8 亿,每天上传的相册文件有 4 亿个,每天读写操作约 10 亿次,在线人际关系链超 1000 亿,这背后是海量数据;Qzone 空间日均相册上传超过4 亿,日写操作总数过 10 亿,数据的传送无疑是高速的。还有多变的位置、环境(雾霾、下雨、紫外线)、时间、实时行为、状态……由于推荐与用户所处的位置、环境、时间、行为、状态等因素关系非常密切,而且这些因素是多变的。这就要求推荐模型建好之后,在这个模型里找用户的特征,再向用户推荐相应的内容。这个模型要随着用户特征的变化实时更新。目前,腾讯的推荐系统大概每 15 分钟要更新一次,即调整参数。

以前的数据分析只有两种方式:一是人工建模,二是机器学习。

人工建模是靠专家长期积累下来的经验去建立一个固定的初选模型,采集的数据按照这个模型来计算并得出结果,这个模型不经常变化,而且数据的输入输出都比较简单,数据量也不太大。以腾讯推荐系统为例,如果用人工建模方式,通过专家来分析,一两个月都难以完成,因此,腾讯推荐系统必须依靠机器来建立和更新模型,也就是机器学习,这样才能做到 15 分钟更新一次模型,因为这是靠机器来建立对应的关系。腾讯推荐系统的特点是数据量大、模型变化快。现在,机器学习技术成为智能数据分析的主流,通过训练让机器得到从数据中提取知识的能力。

当前,人工分析方法展现出新的进展,就是靠软件编辑起来的深度神经网络来进行数据分析。上世纪 80 年代发现,人脑认知过程是分层的,但人们对传统神经网络的认识不够精细,神经元的数量也不太多。2006 年,Geoffrey Hinton 提出增加神经网络层数和每层的神经元数量,就可以显著地提高数据分析的效果。数据分析技术的下一步发展在于深度学习(deep learn-ing) 算法研究和大规模神经网络构建。

目前,深度学习取得了很多初步的应用成果,特别是在语音识别中,Siri 出现的时候只是作为一种玩具,并不是很好用。而谷歌的语音识别已经做得比苹果好很多。现在微软也在做,就是用深度神经网络来识别用户的语音,而且它正在做实时翻译,即把语音从英语经过机器系统之后翻译成中文的文字和话音,而且准确率非常高,错误率从 23%下降到 15%。这说明,采用了大数据技术之后,十年以来没有降低的错误率显著下降了。图像也是一样的,深度学习技术将图像识别的准确率从 2010 年的 72%提高到 2012 年的 85%。随着训练样本的增加,机器处理的复杂度还会提升。

数据展现技术

让大数据更加贴近大众的重要手段是数据可视化 (Visualiza-tion)。可视化是通过图形的表现形式,进行信息传递、表达的过程,它是美学形式与功能需要齐头并进,是技术和艺术的结合。它能够将版本复杂的数据很直观地展示出来。1986 年,美国 NSF 正式提出可视化的概念,并将其列为一项独立的计算机技术。

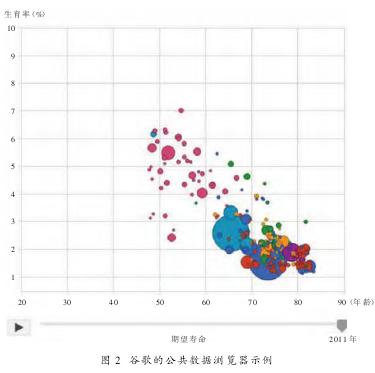

典型的可视化应用是谷歌的公共数据浏览器,如图 2 所示。

谷歌收集全世界公开的数据,它把 1970 年到 2011 年全世界很多国家的生育率和平均寿命做在一张图上,并可通过动画直观地展示出来。图中比较大的两个点是印度和中国,点越大表示人口越多。

由图可见,起初中国和印度人的期望寿命很低,但是出生率很高。之后,人口一直在往下降。谷歌把复杂的数据用这种直观的方式展现出来,而且,奇妙的是,采用谷歌的可视化应用,用户可以自己定义纵轴和横轴分别代表什么,然后分析这两个数据之间的关系。而以前,要进行这样的分析并发现趋势是一个很复杂的过程。此外,谷歌还做了查询词的可视化。它在类似地球的图形上展现出搜索请求在全世界的分布,并将点击量用线条表示出来。如果要看世界不同地方查询词点击量的分布,只要把鼠标移到地图上相应的地方就可以。

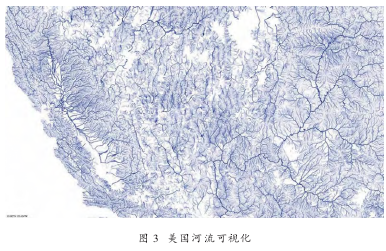

淘宝也在做数据可视化。它用图形展示出买家购物的流向,比如,商家在北京,买家在上海,购买过程呈现出哪些关系。Linkedin 做出了某人社交关系的可视化图形,从图上可以看出,此人与哪些用户的关系很密切,与哪些用户的关系则很生疏。美国一家网站做了河流的可视化(见图 3),在图上甚至能直接看到小溪的情况。

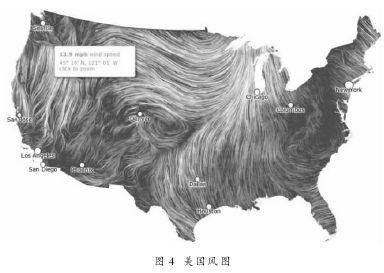

图 4 是美国的风图。该网站用动画的形式展现风向,用户能够实时看到风向是如何变化的。据说,有一次在洛杉矶发生大火,消防员就是靠这个图来判断风向去救火,这张图为成功救火发挥了很大的作用。

可以说,数据可视化并没有涉及太多核心技术,更多的是人机界面、人机交互领域的应用。而数据展现技术未来的发展方向就是面向人机互动的可视化知识呈现。我国缺乏体系化原创技术在国际上,大数据技术创新形成了“互联网公司原创→开源扩散→IT 制造商产品化→其他企业使用”的明显格局。

全球的企业分为三个阵营。第一阵营是谷歌,该公司在很多领域将大数据技术应用了 4~5 年左右的时间,才将它向业界公开。又经过 3~4 年的时间,一些公司联合起来做了开源的实践,这些企业处于第二阵营。之后,再经过 2~4 年的时间,像 IBM、Intel 等公司可能利用开源做出了一些商业化的产品,这些企业也成为大数据技术创新的第三阵营。在这三个阵营中,谷歌输出的是原创技术;雅虎、Face-book 以及一些开源社区将创新技术工程化和开源化;而传统的 IT公司做的是产品的商业化。

我国在大数据技术创新方面比较落后。目前,腾讯、百度、阿里巴巴等几家大型互联网公司仅在应用方面比较先进,能够在开源出来后很快消化开源软件,并应用到自己的业务中。华为、浪潮等制造商/软件商的相关商用产品提供落后于国际同类厂商 1~2 年。总体而言,我国企业比较侧重大数据技术的工程优化,缺乏体系化性原创技术,而且新技术扩散的通道不畅,要提高技术创新水平,尚需提炼重点突破的技术方向。